【转】Mongodb Replica Sets 副本集架构实战(架设、扩充、容灾、修复、客户端代码连入)(9)

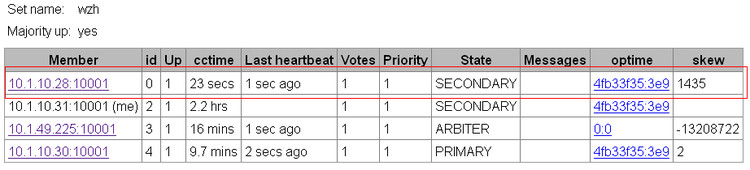

现在我们一共10W2000条数据了,很快模拟故障修复了,我们正常启动28节点了,很明显30节点当老大很爽,不愿意将老大的位置再让回给28了:

经过查询,发现28节点的数据也已经是10W2千条了,在28down的过程中,新增加的1000条数据已经同步过去拉。

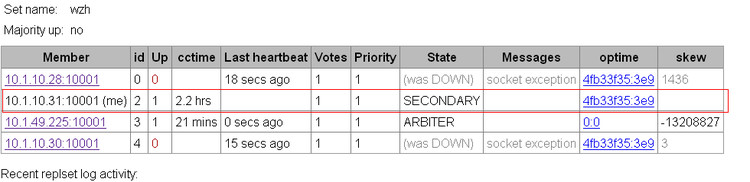

2、同时意外崩溃2个节点

我们现在同时将副本集内的2个节点kill掉,模拟一个比较大的灾难。

上图可以看到只剩下31一台节点苦苦支撑了,另外2个兄弟已经down了,这时副本集中可用的数据节点只有1个了,仲裁服务器无数据的,所以自动降级为secondary,这时整个集群只可读,不可写。我们尝试往31数据库插入一些数据.

SECONDARY>var tags =["nn","nn","vv","yy","ii","kk","gg","ee","aa"];for(var i=0;i<1000;i++){

... db.test.insert({"name":"groupa","tags":tags})

...}

not master